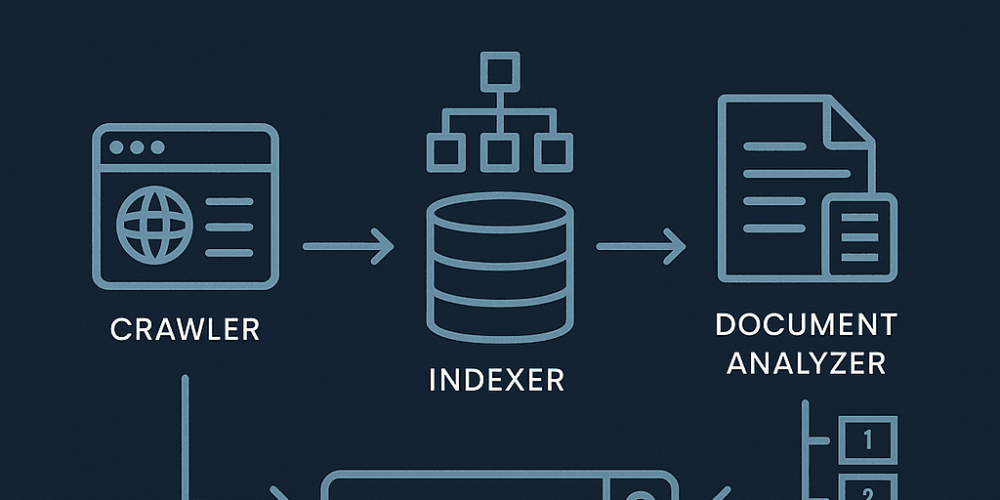

Wer verstehen will, wie Search Engine Design funktioniert, sollte die zugrunde liegende Architektur moderner Suchmaschinen kennen. Eine Suchmaschine besteht aus mehreren Modulen – vom Crawler über den Indexer bis zur Query Engine.

Jedes dieser Module übernimmt eine konkrete Aufgabe, damit Millionen von Nutzer in Millisekunden passende Ergebnisse finden. In diesem Beitrag zeigen wir Ihnen, wie genau Suchmaschinen Inhalte analysieren, gewichten und anzeigen – technisch nachvollziehbar und einfach erklärt.

Der Crawler sammelt das Web

Jede moderne Suchmaschine startet mit einem Crawler. Dieser Bot ruft Webseiten ab, speichert ihren Inhalt und folgt Links zu weiteren Seiten. Ziel ist es, so viele öffentlich erreichbare Dokumente wie möglich zu erfassen.

Seitenbetreiber steuern über die Datei robots.txt, was gecrawlt werden darf und was nicht. Große Suchmaschinen durchforsten regelmäßig Milliarden von Seiten und halten ihren Datenbestand dabei stets aktuell.

Der Document Analyzer extrahiert Informationen

Nach dem Speichern analysiert der Document Analyzer jede Seite systematisch. Dabei kommen verschiedene Verfahren zum Einsatz:

- HTML-Parsing: Der Quelltext der Seite wird strukturell zerlegt, um Tags wie

<title>,<h1>,<meta>oder<p>zu erkennen. - Spracherkennung: Algorithmen wie LangDetect bestimmen, in welcher Sprache die Seite geschrieben ist.

- Extraktion semantischer Merkmale: Dazu gehören Titel, Zwischenüberschriften, URL, ein Textauszug (Snippet) und bei Bedarf auch eine Stimmungsanalyse (Sentiment Detection).

- Erkennung strukturierter Daten: Wenn vorhanden, werden strukturierte Daten wie JSON-LD, Microdata oder OpenGraph-Tags ausgewertet.

Das System speichert alle gewonnenen Informationen in einem zentralen Metadaten-Repository. Ranker und Query Engine greifen später darauf zu, um Inhalte besser zu bewerten und darzustellen.

Der Indexer erstellt den Suchindex

Im nächsten Schritt verarbeitet der Indexer die Seiteninhalte zu einem durchsuchbaren Index. Technisch läuft das in mehreren Schritten ab:

- Tokenisierung: Der HTML-Text wird in einzelne Wörter (Tokens) zerlegt. Satzzeichen verschwinden, Groß- und Kleinschreibung wird vereinheitlicht.

- Stopwort-Filterung: Häufige, wenig aussagekräftige Wörter wie „der“, „und“, „ist“ werden entfernt.

- Stemming: Der Prozess reduziert Wörter auf ihre Grundform. Aus „laufend“, „gelaufen“ und „läuft“ wird z. B. „lauf“.

- Normalisierung: Das System wandelt Umlaute und Sonderzeichen um (z. B. „münchen“ → „munchen“).

- Inverted Index: Für jedes verbleibende Wort entsteht eine Liste von Dokument-IDs, in denen das Wort vorkommt. Diese Struktur bildet das Herzstück jeder Suchmaschine.

Beispielstruktur eines invertierten Index:

| Begriff | Dokumente |

|---|---|

| afrika | 9, 18, 45 |

| jungle | 9, 10, 27 |

| safari | 18, 27, 88 |

Der Index bleibt nicht statisch – das System aktualisiert ihn regelmäßig. Die Query Engine nutzt ihn, um Suchanfragen schnell zu beantworten.

Der Document Ranker bewertet Relevanz

Nicht jede Seite ist gleich wichtig. Deshalb bewertet der Document Ranker jedes Dokument nach festen Regeln:

- Wie oft taucht ein Wort auf?

- Steht es im Titel oder in Überschriften?

- Verweisen viele hochwertige Backlinks auf die Seite?

- Wie oft klicken Nutzer:innen darauf?

Das System ordnet den Ergebnissen einen Relevanzwert zu. Je höher der Wert, desto weiter oben erscheint das Dokument in den Suchergebnissen.

Die Query Engine liefert Ergebnisse

Sobald jemand einen Suchbegriff eingibt, ruft die Query Engine passende Dokumente aus dem Index ab. Danach sortiert sie die Ergebnisse anhand ihrer Relevanz und stellt sie dar:

- mit URL

- mit einem kurzen Textauszug

- mit der passenden Überschrift

Je besser Inhalt und Suchanfrage zusammenpassen, desto höher landet das Ergebnis. Auch KI-Suchsysteme wie ChatGPT nutzen diese Architektur – oft kombiniert mit semantischen und kontextbasierten Verfahren.

Fazit

Die Architektur von Suchmaschinen ist modular, logisch aufgebaut und technisch faszinierend. Wer die einzelnen Komponenten wie Crawler, Indexer und Ranker versteht, kann gezielt Einfluss auf die Sichtbarkeit von Inhalten nehmen.

Ob bei klassischen SEO-Maßnahmen oder im Zusammenspiel mit modernen KI-Systemen – dieses Wissen bietet einen echten strategischen Vorteil.